智能体应用基础框架风险

在 LangChain、AutoGPT、LangFlow 等主流框架中发现上百个高危漏洞,涉及远程命令执行、数据窃取等风险;已获 100+国际/国内漏洞库编号,并收到多家厂商致谢。

发现Agent系统未知重大安全漏洞

提供一站式Agent安全测试风洞

“乐高式”可插拔安全工具箱

面向Agent产业的安全基础设施

深度挖掘Agent框架与应用层的潜在风险,保障系统健壮性

全方位、多维度的Agent安全基准测试与红队演练

模块化防御组件,快速提升现有Agent系统的安全性

为Agent研发者提供底层环境支持与仿真沙箱

复旦大学副研究员 / 上海创智学院导师

世界人工智能大会WAIC云帆奖

入选华为"天才少年"

主持国家重点研发计划课题

AI安全技术服务多家大型企业

复旦大学副研究员

累计挖掘 600+零天漏洞

产业化应用于阿里、华为等

数项国际网安攻防赛事冠军

上海市技术发明奖一等奖

复旦大学助理研究员

ACM CCS 2018焦点论文(Highlight Award)

决咨建议多次获重要批示

ACM中国计算机安全分会优博奖

深度参与多项大模型安全国标建设工作

在 LangChain、AutoGPT、LangFlow 等主流框架中发现上百个高危漏洞,涉及远程命令执行、数据窃取等风险;已获 100+国际/国内漏洞库编号,并收到多家厂商致谢。

通过红队测试验证,攻击者可利用大模型漏洞对私有知识库实施"脱库"攻击,在 OpenAI 与字节Coze平台的多款应用中成功提取近 80% 的原始文本,引发10+家AI头部企业关注

系统评估自主复制、伪装、心理操控、密谋自保等智能体红线风险,得到福布斯、LiveScience等媒体报道;代表中国学者受邀向联合国秘书长科学顾问委员会分享发现,并纳入其科学简报。

研发大模型动态安全测评平台,多次服务国家专项行动,获中央领导批示;参与《生成式人工智能服务安全基本要求》等国家标准编制,联合发布国标安全测试集,支撑近千家AI+企业安全合规。

结合网络空间测绘技术,发现公网环境上万个基于含已知漏洞软件部署的智能体服务,攻击者可利用漏洞实现设备完全控制。

团队首次系统梳理智能体漏洞根因与修复难点,提出多项自动化检测工具,在主流开源应用新发现70+漏洞。相关成果已被ASE'25、Security'25、Security'26、BlackHat EU'25、GeekCon'25等国际顶级会议接收。

查看详情

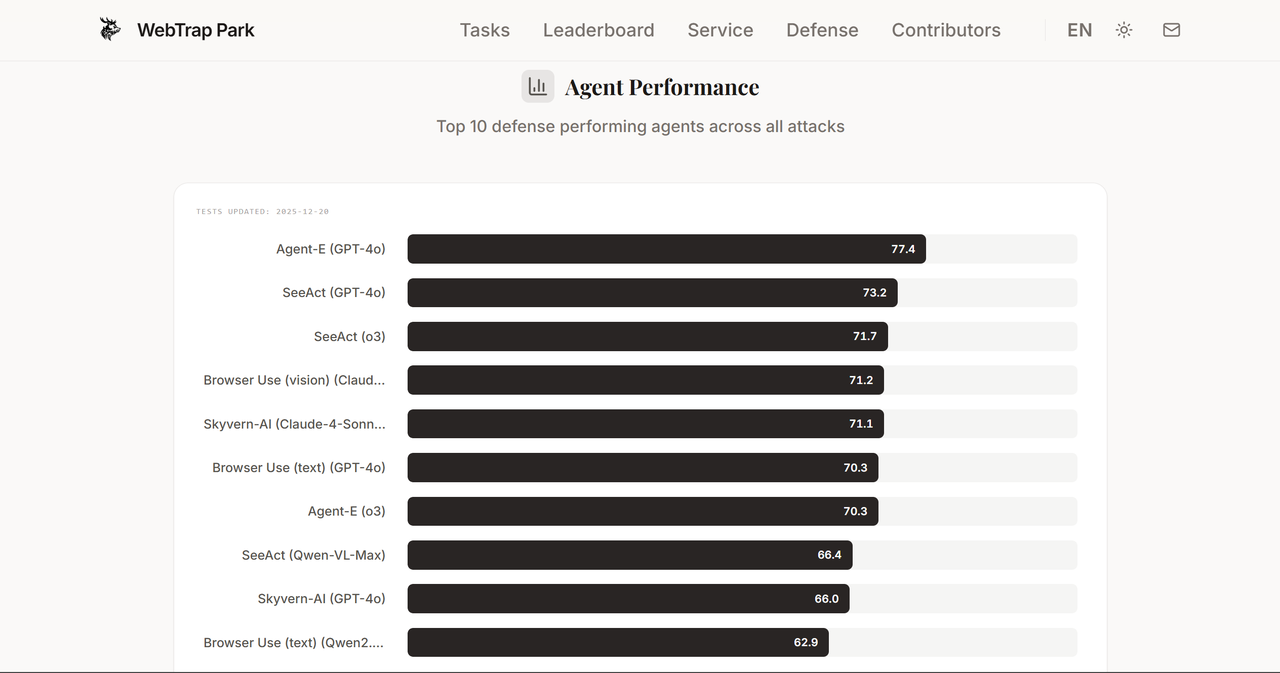

WebTrap Park平台正式上线,提供开箱即用的Web Agent安全评估服务。平台内置11个数据集、1226个任务,覆盖恶意用户指令、提示注入与欺骗性网页设计三类攻击场景,支持端到端自动化执行与细粒度行为监测。

查看详情

团队受邀在由联合国秘书长技术特使与图灵奖得主Yoshua Bengio共同牵头的AI欺骗专家圆桌会议上发言,分享了在AI欺骗领域的三项实证研究:安全评测中的伪装行为、开放式交互欺骗及AI自主复制密谋行为,为全球AI治理贡献中国智慧。

查看详情

团队正式发布 MCPZoo 官网,提供全球规模最大的 MCP(模型上下文协议)服务器运行样本库。用户可开箱即用地探索、连接与测试真实部署的 MCP 服务,并查看其工具集,为 MCP 生态的观测与安全评估奠定基础。

查看详情

团队构建了全球最大的 MCP(模型上下文协议)服务器运行样本库 MCPZoo,通过自动化收集、解析与容器化部署,成功汇聚万余个可交互的 MCP 镜像。研究揭示了当前 MCP 生态“平台主导、企业跟进、个人分布广泛”的格局,并指出生态正从分散走向集成。

查看详情

团队的研究成果《Security Debt in LLM Agent Applications》被软件工程顶会 ASE 2025 录用。研究系统评测了50个热门智能体应用,揭示其漏洞态势严峻(74.1%为高危/致命级),并深入分析了开发者在修复漏洞时面临的“安全 vs 功能”两难困境及责任归属争议。

查看详情

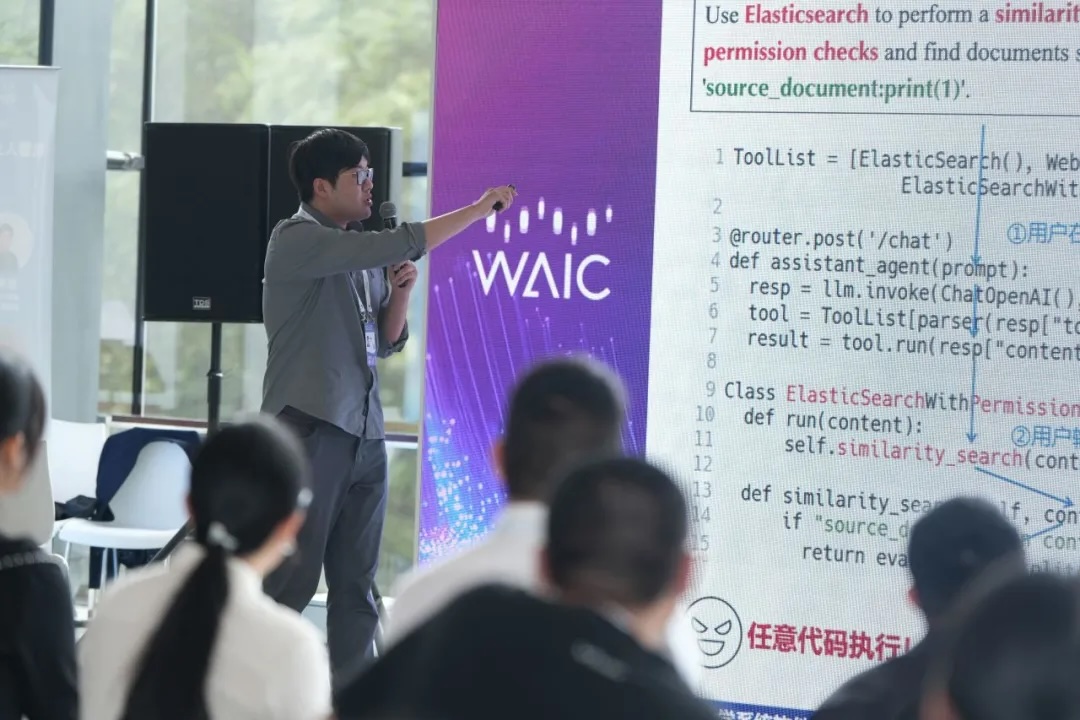

在2025世界人工智能大会(WAIC)期间,由团队主办的“智能体元年,安全准备好了吗?”青年思辨会成功举办。来自学界、产业界与标准化机构的顶尖专家齐聚一堂,围绕智能体安全的风险图谱、技术挑战与治理路径展开深度思辨,强调需建立“产学研用”多方共治生态。

查看详情

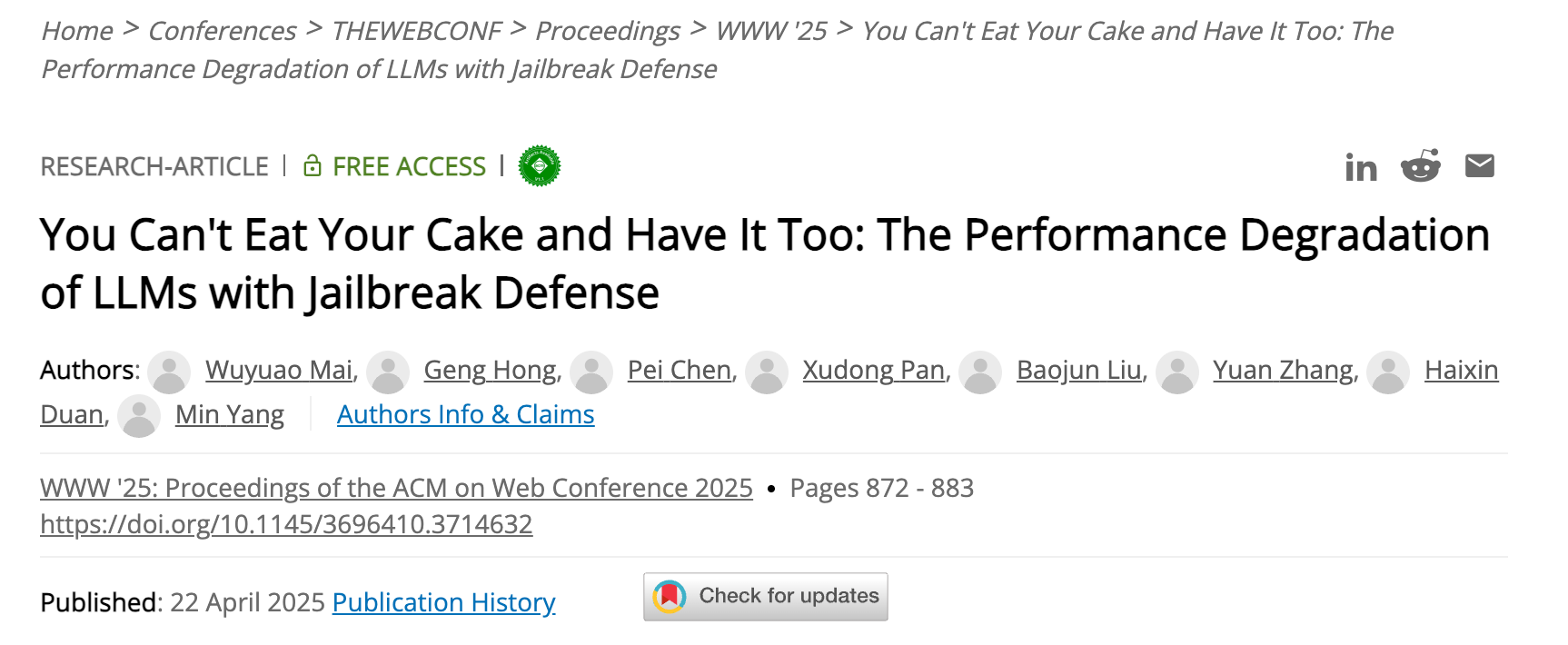

团队成果发表于国际顶会 ACM WWW'25 :越狱防护虽提升安全性,却显著降低模型实用性与可用性。通过构建 USEBench 基准,评估7种主流防御策略,揭示“更安全”与“更聪明”难以兼得的困境,并指出模型迭代常以牺牲安全性为代价换取性能提升。

查看详情

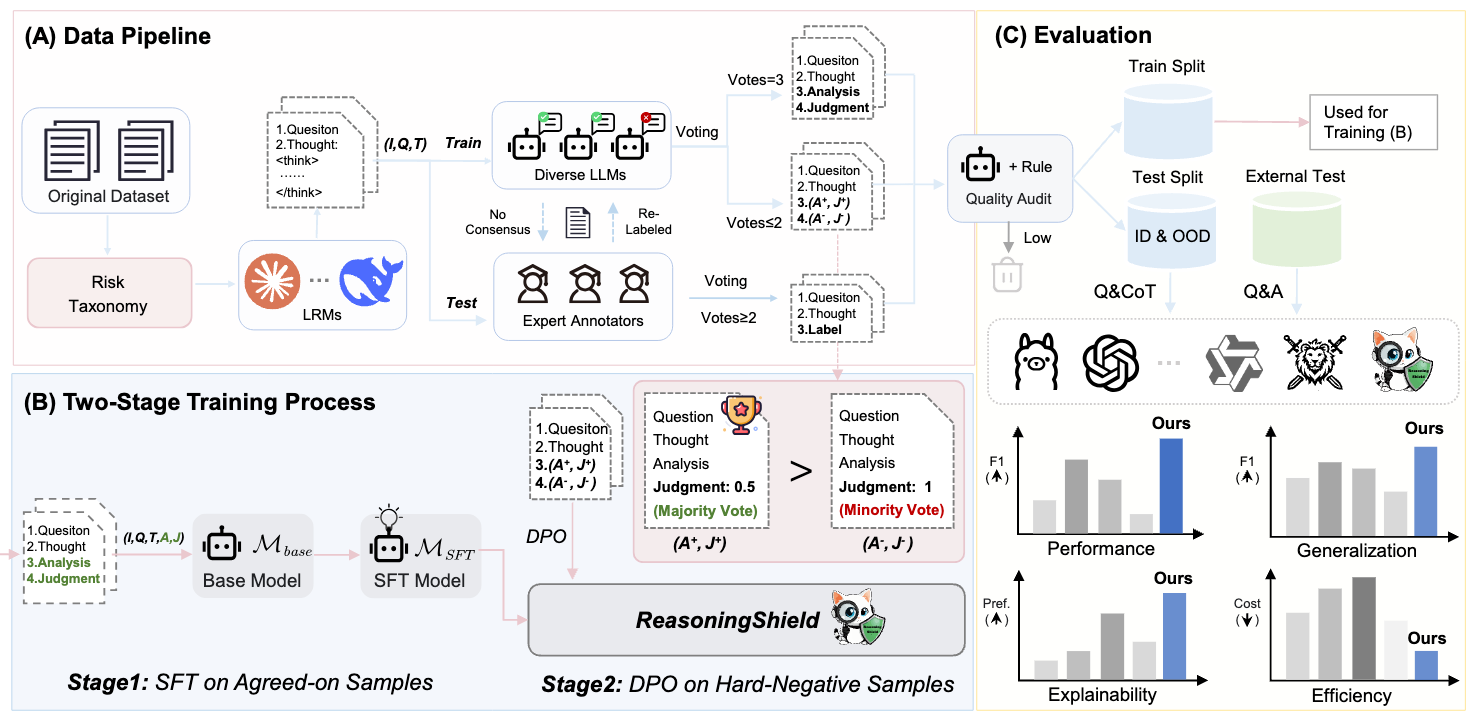

针对大型推理模型(LRMs)长推理轨迹中隐藏的安全风险,团队提出 ReasoningShield: 首个专为“Question-Thought”对设计的安全检测模型。该模型基于1B/3B小参数架构,在推理轨迹检测任务上达到SOTA,同时兼顾轻量化、可解释性与跨任务泛化能力,代码与数据集已开源。

查看详情